Ioan Marius Bilasco

Axes de recherche

Analyse faciale dans les flux vidéo

Reconnaissance des expressions

En partant du constat que la normalisation du visage permet d'améliorer les processus de caractérisation faciale, nous avons exploré la reconnaissance de la joie, en nous appuyant sur l'approche de normalisation mise en place pour la reconnaissance du genre. Ces travaux ont permis de construire des masques de pixels sur les visages, capables d'améliorer la reconnaissance de l'expression de joie à partir de l'intensité de pixels sans passer par des descripteurs complexes [AJI_DBMD_13]. Les travaux conduits sur des images ont été poursuivis par les recherches menées dans le cadre de la thèse de Benjamin Allaert. Ces travaux visent à reconnaître des expressions à intensité variée (de micro- à macro-expressions). En s'intéressant au défi posé par la variabilité de l'intensité des expressions, nous étudions une approche tenant compte des caractéristiques physiques de mouvements faciaux [AJI_ABD_19]

|

|

|

Impact de la normalisation sur la reconnaissance d’expressions

Afin de contourner le problème relatif aux mouvements de tête, la plupart des méthodes proposent d'employer des techniques de normalisation du visage. Cette normalisation induit des déformations de texture qui interfèrent avec les expressions.

Dans [AJI_AMBD_18]typo3/ nous avons proposé une méthodologie et un corpus de données, Synchronous Natural and Posed 2D Facial Expressions (SNaP-2DFE), qui permettent de quantifier l'impact de la normalisation sur la reconnaissance des expressions faciales.

|

|

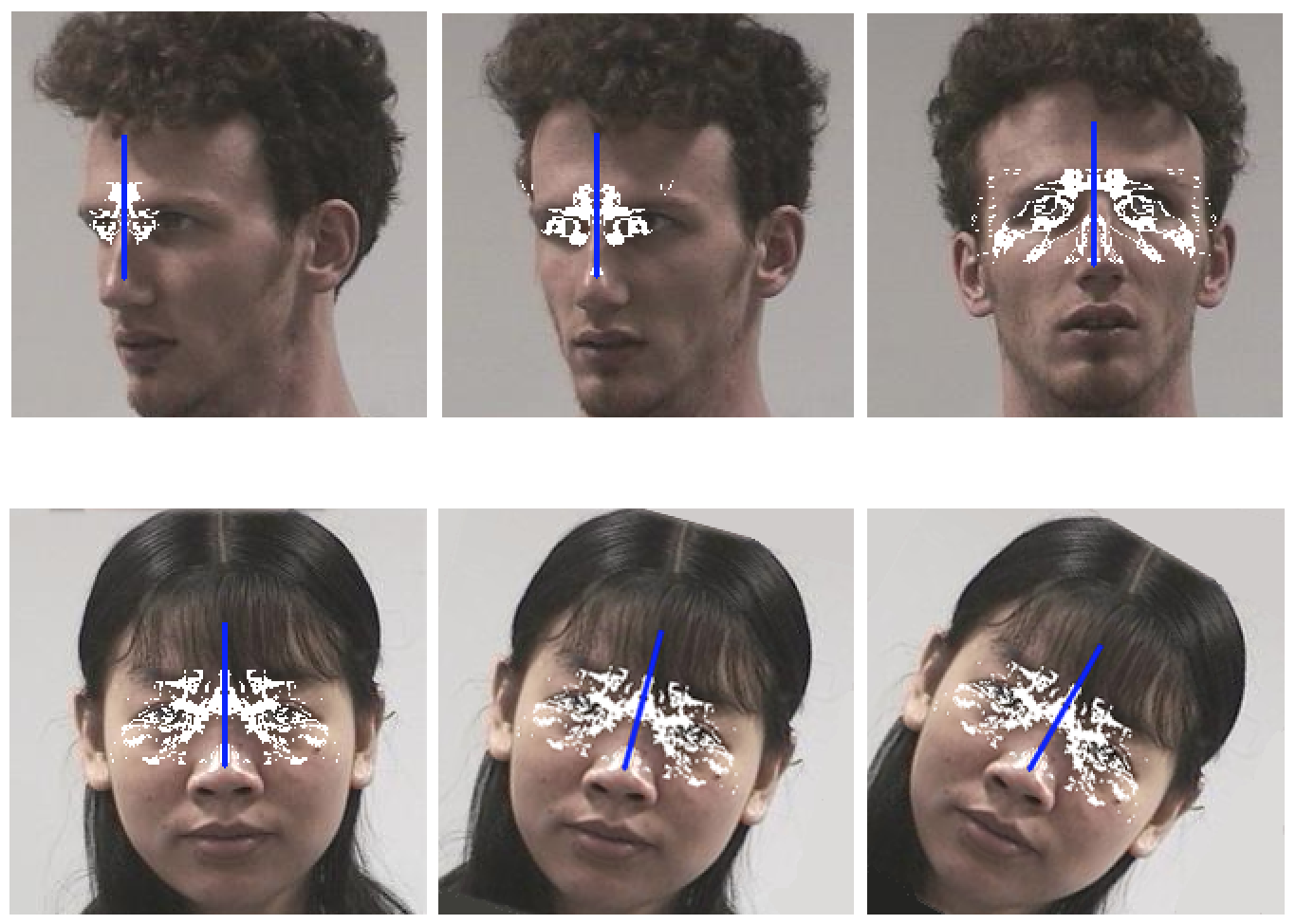

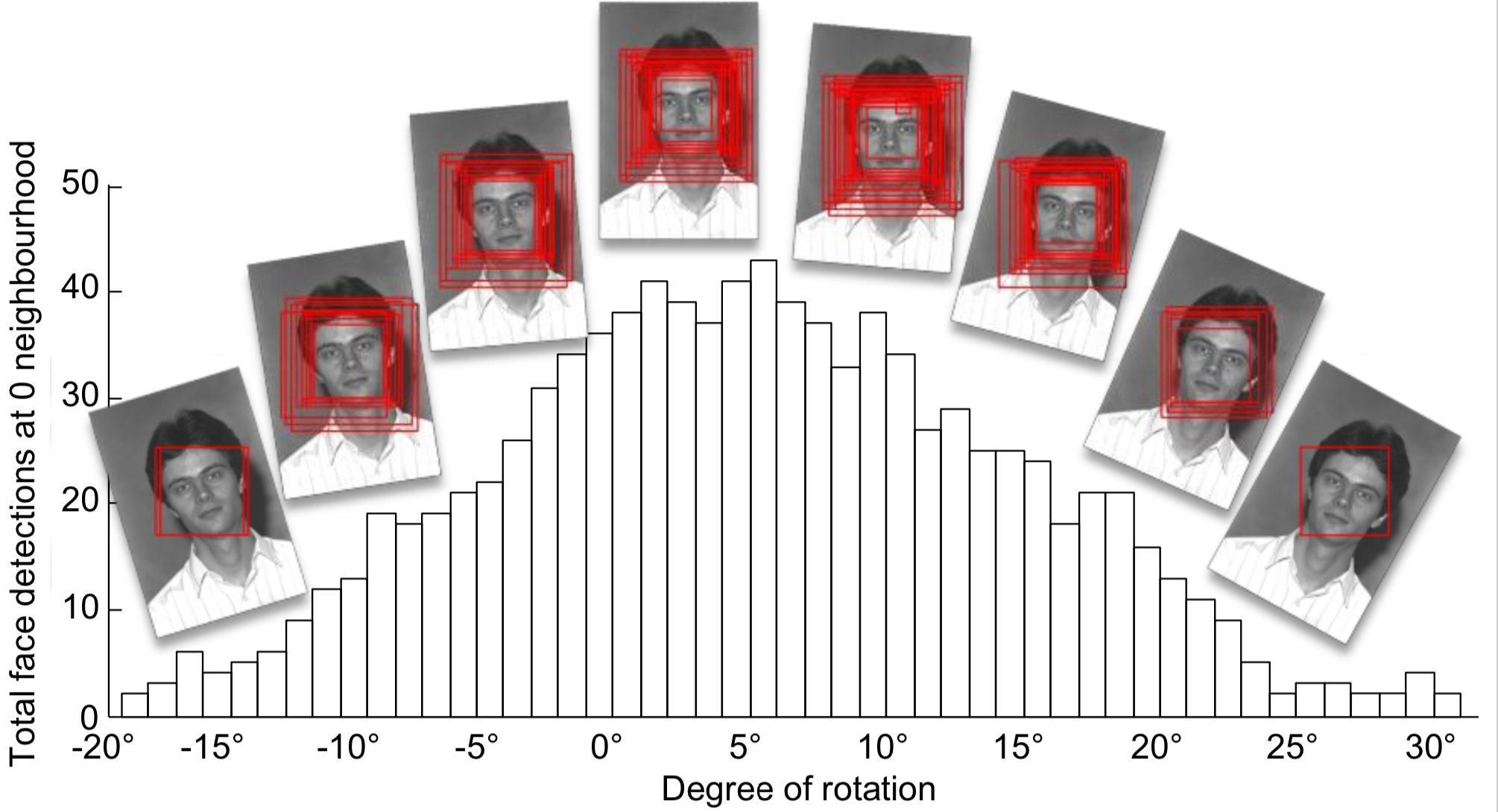

Estimation de l'orientation de la tête

Afin d’estimer l'orientation de la tête, dans le cadre de la thèse d'Afifa Dahmane, nous avons proposé une approche basée sur la symétrie du visage [AJI_DSBC_15]. D’autres travaux sur ce sujet ont été menés en collaboration avec les post-doctorants Taner Danisman et José Mennesson et valorisés dans [AJI_DB_16] et [ACI_MDDB_16]

|  |

Reconnaissance d’expressions en présence d’occultations

La ligne directrice confortée par les travaux initiés avec Benjamin Allaert se poursuit avec la thèse de Delphine Poux qui a démarré en octobre 2017. Les premiers résultats montrent que l'exploitation du mouvement trouve également sa place dans la reconnaissance des expressions en présence d'occultations dans [ACI_PAMIBD_18].

|  |

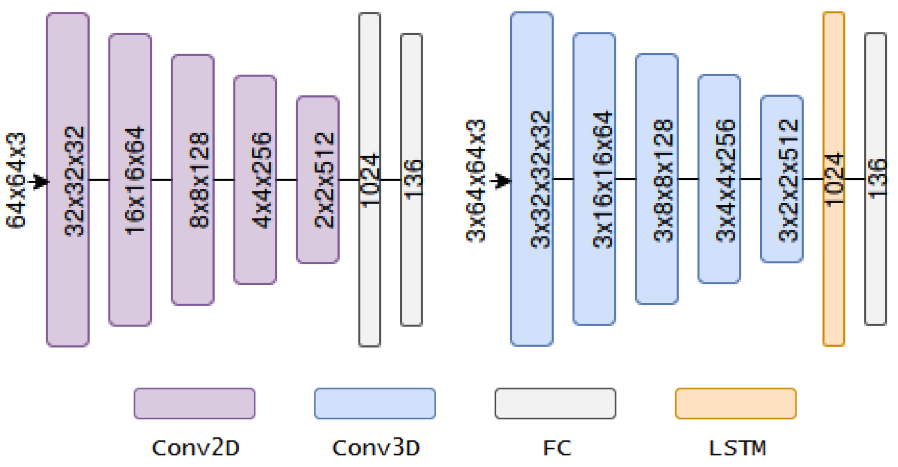

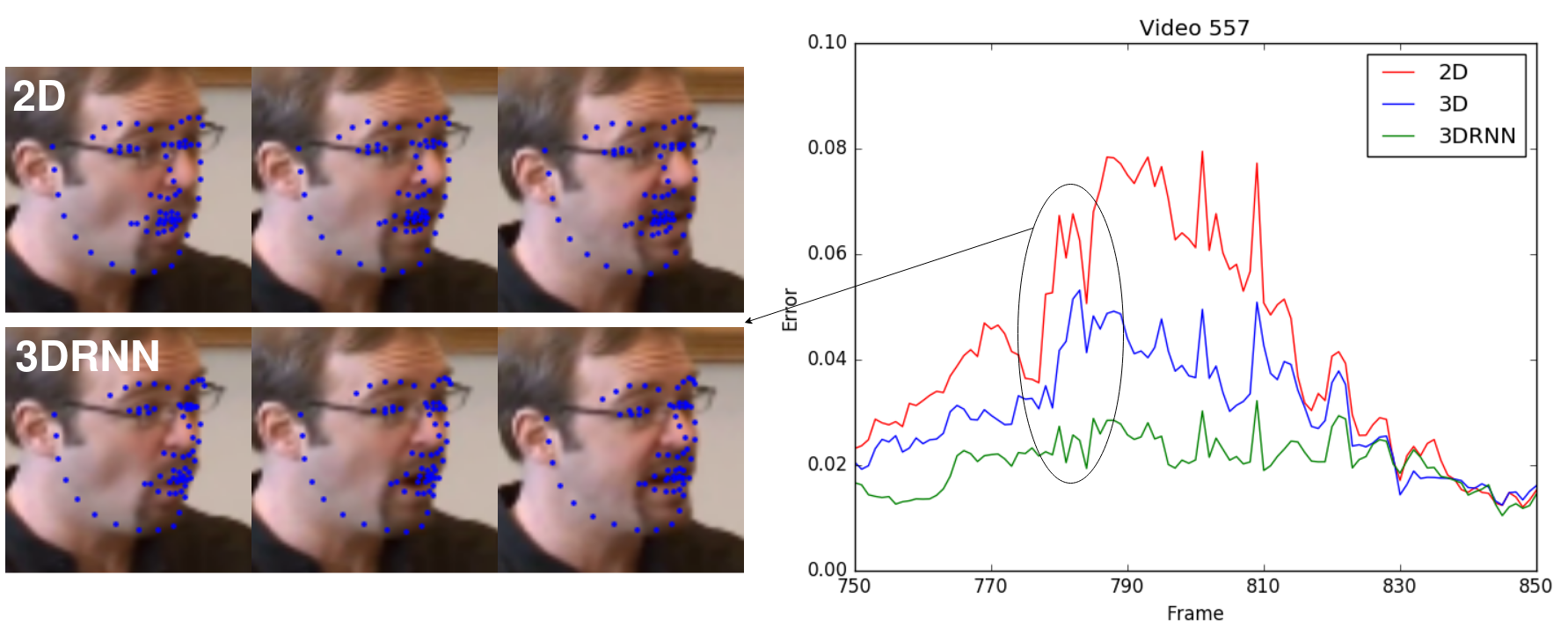

Localisation de points caractéristiques de visages

Dans la thèse de Romain Belmonte, en collaboration avec l'École d'ingénieurs des Hautes Technologies et du Numérique (ISEN - YNCREA), nous avons exploré les processus d'apprentissage profond pour la prise en compte de l’évolution cohérente dans le temps du suivi des points caractéristiques du visage pour améliorer la précision des détections [ACI_BTBD_19]typo3/.

|

|

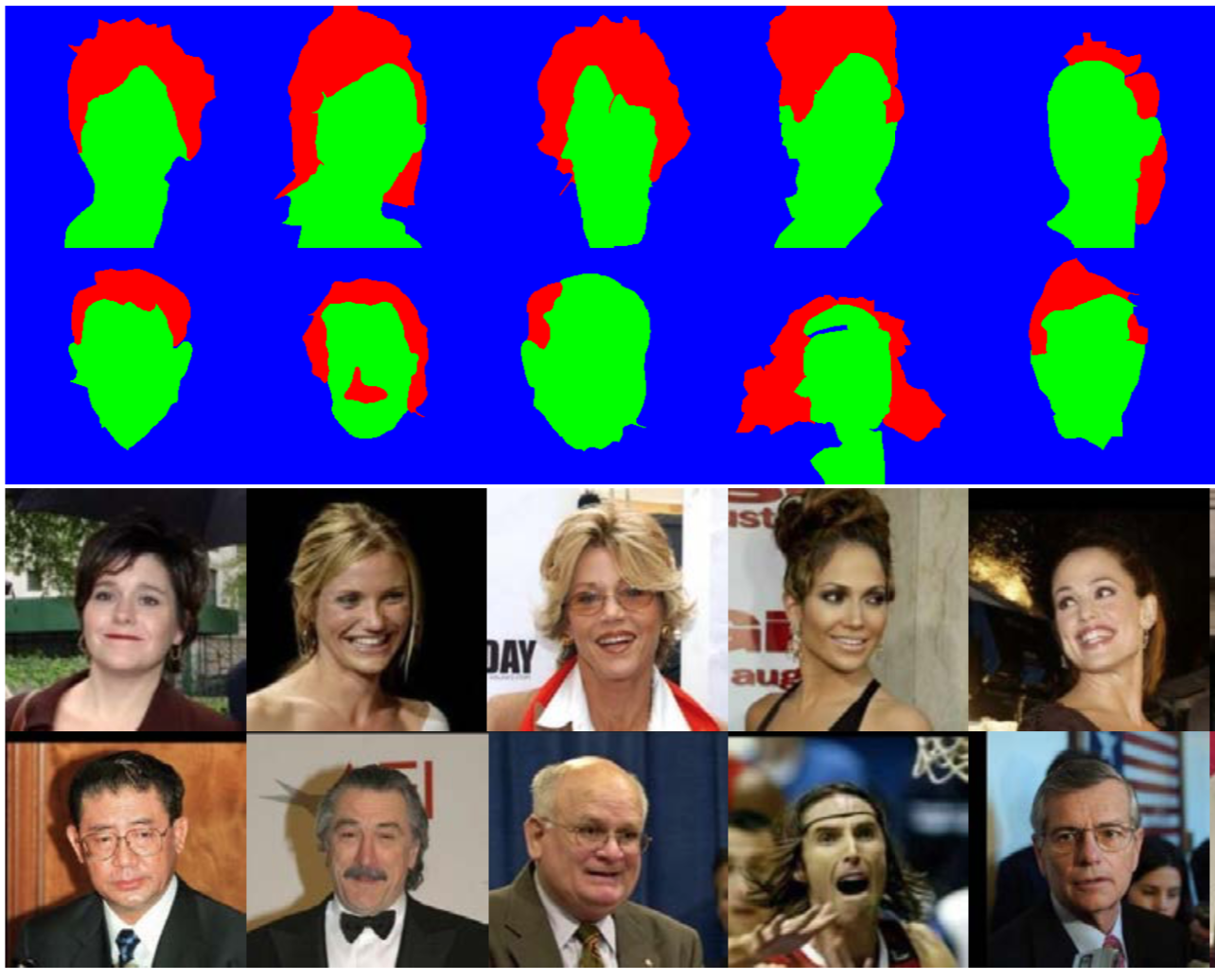

Reconnaissance du genre

La biométrie douce permet de différencier les individus sur la base de leurs traits caractéristiques (par exemple, la couleur des yeux, la forme du visage, le genre), sans toutefois les identifier précisément. Nous avons proposé une méthode globale fonctionnant dans des conditions difficilement abordables (par exemple, taille d'images très petite, faible illumination). Des résultats intéressants ont été obtenus dans un contexte de validation croisée entre différentes bases de données [ACI_DBD_14]. Toutefois, la reconnaissance du genre en se basant uniquement sur l’intérieur du visage présente des limitations. Par exemple, certains individus ont des traits plus proches du sexe opposé que du leur. Ainsi, nous avons poursuivi ces travaux en les enrichissant avec des informations caractérisant à la fois, des éléments précis à l'intérieur du visage (moustache, barbe) et des éléments entourant le visage (comme les cheveux) [AJI_DBM_16]

|

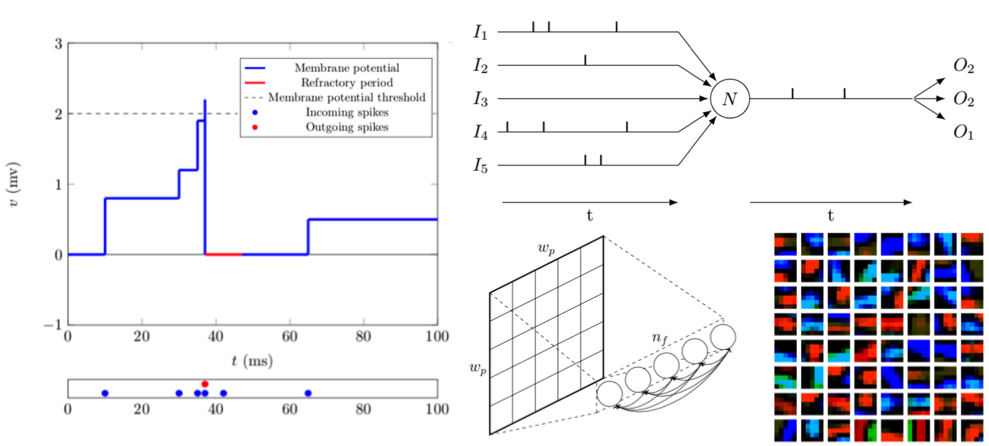

Approches neuromorphiques pour la vision par ordinateur

Les processus d'apprentissage se trouvent au cœur de l'ensemble des travaux évoqués jusqu'ici. Depuis 2014, nous nous intéressons à des processus d'apprentissage non-supervisés sur la base de réseaux de neurones impulsionnels. Entourés par des collègues intéressés par la simulation (équipe Emeraude, lab. CRIStAL) de ces réseaux, nous explorons des problématiques liées aux besoins de la vision (réseaux de taille importante, encodage de l'information, etc.). En étroite collaboration avec Pierre Tirilly (MCF, équipe FOX, lab. CRIStAL), Philippe Devienne (CR CNRS, équipe Emeraude, lab. CRIStAL) et Pierre Boulet (PR, équipe Emeraude, lab. CRIStAL), nous avons encadré les travaux de Pierre Falez autour de l'apprentissage non-supervisé de descripteurs à base de réseaux de neurones impulsionnels et de mécanismes bio-inspirés de type spike-timing dependent plasticity (STDP) [AJI_FTBDB_19][ACI_FTB_20][ACI_FTBDB_19][ACI_FTBDB_18].

|

Projets collaboratifs

J’ai participé au montage et au pilotage local de 3 projets de recherche européens labélisés dans le contexte de programme cadre ITEA du cluster EUREKA :

· TWIRL – Twinning virtual World (on-line) Information with Real world (off-Line) data sources (2012 - 2014)

· EMPATHIC - Empathic Products : Enabling intention- and emotion-aware products (2012 - 2015)

· PAPUD – Profiling and Analysis Platform Using Deep Learning (2018 - 2020)

En janvier 2013, j’ai monté avec Chaabane Djeraba (PR, équipe FOX, lab. CRIStAL), une collaboration avec l’entreprise IKOMOBI.

Au delà de ces projets dont j’ai suivi la création et la réalisation, dans le cadre du projet ITEA2 Collaborative Aggregated Multimedia for Digital Home (CAM4HOME, 2007-2010) j'ai coordonné avec Chaabane Djeraba (PR, équipe FOX, lab. CRIStAL) les activités du groupe de travail autour de la modélisation sémantique des métadonnées. Ce projet a reçu la médaille d'argent lors du symposium ITEA-ARTEMIS organisé à Ghent, Belgique en 2010.

J'ai participé également au projet ITEA2 Multimodal Interfaces for Disabled and Ageing Society (MIDAS, 2008-2011). Je suis intervenu avec Chaabane Djeraba (PR, équipe FOX, lab. CRIStAL) à la fois sur des aspects recherche autour de la reconnaissance des expressions et de l'endormissement ainsi que dans les développements en vue de préparer les démonstrateurs associés.

Je suis intervenu également dans le cadre du projet ANR Comportements ANormaux : Analyse, Détection, Alerte (CAnADA, 2008-2011) sur la modélisation du mouvement dans un contexte de foule.

Je participé sous la coordination locale de l'équipe Modeling and Analysis of Static and Dynamic Shapes (3D-SAM) de CRIStAL, dans le montage d'un projet financé sur Fonds Unique Interministériel (FUI) : Mesure Analyse Gestion de flux Nativement Unifiée dans des Malls (MAGNUM2, 2014-2016).

PAPUD – Profiling and Analysis Platform Using Deep Learning

| ITEA3/FUI - 2018-2020 labellisé en 2017 23 partenaires, 6 pays coordonné par Atos Bull France https://itea3.org/project/papud.html

|  |

Le projet PAPUD a pour but de créer de nouveaux modelés et algorithmes dédies à l’analyse de grandes masses hétérogènes issues de différentes applications. Étant donné que les méthodes classiques d’apprentissage ont déjà̀ montré leurs limitations, dans le cadre de ce projet, l’apprentissage profond est préconisé́ comme approche principale. L’apprentissage profond implique la prise en compte des problématiques liées au passage à l’échelle.

Dans le cadre du projet, j’ai notamment participé à la définition d’un scénario qui concerne l’exploitation des traces d’usage des utilisateurs. Lors des interactions avec un système, une multitude de traces d’exécutions et de logs sont collectés. Souvent ces données sont exploitées dans la maintenance applicative ou dans la construction des profils utilisateurs basée sur l’historique de navigation. Les informations recueillies restent objectives et ne permettent pas de renseigner, par exemple, sur la perception subjective de l’expérience utilisateur, sur un produit ou un e-service.

Je m’intéresse plus particulièrement à un processus d’inférence de mesures subjectives (état cognitif et affectif) à partir d’un ensemble de mesures objectives fournis par des caméras vidéo ou biocapteurs. Pour cela, nous exploitons des corrélations entre mesures subjectives et objectives obtenues dans le cadre des expérimentations conduites dans un living lab instrumentalisé. Les traces objectives produites par les utilisateurs dans leur interactions, ainsi que les traces subjectives sont analysées conjointement afin d’identifier des corrélations qui sont exploitées pour inférer des traces subjectives lorsque, dans un contexte réel, uniquement les traces objectives sont disponibles. Ces résultats permettent d’envisager de construire des profils cognitifs et affectifs des utilisateurs de manière transparente et sans aucune instrumentalisation spécifique.

Mes publications en lien avec le projet PAPUD sont les suivantes : [AJI_ABD_19][ACI_BTBD_19][ACI_PAMIBD_18][ACN_PAIBD_18][PP_PAMIBD_19][PP_BATBDS_19][PP_AWBDB_19].

Empathic Products – Enabling intention- and emotion-aware products

ITEA2 - 2012-2015 |  |

L’objectif de ce projet est d’améliorer l’expérience utilisateur en appliquant des technologies empathiques capables de comprendre et de répondre aux intentions et aux émotions des utilisateurs lors de l’utilisation des applications ou des systèmes déployés dans le monde réel. Les applications empathiques peuvent ainsi percevoir les émotions et les intentions de ces derniers. Ces capacités leur permettent d’adapter en temps réel leur fonctionnement pour optimiser l’expérience utilisateur.

J’ai coordonné le montage du projet pour le compte de l’équipe dès ses prémices en participant à l’événement Project Outline Days organisé à Paris en mars 2011. Depuis son financement, intervenu au mois de septembre 2012, j’ai coordonné localement le projet. Dans le cadre du projet, j’ai eu la responsabilité du sous-lot 3.3 (Modélisation des interactions/comportements utilisateur) et j’ai coordonné les contributions de l’équipe FOX au sein de plusieurs cycles : Empathic Video-Conferencing Systems, Empathic TV, Empathic Bilboard, EmoShop.

Dans ce projet, ma contribution porte sur l’extraction à partir de flux vidéo d’indices sur la manière dont les personnes perçoivent leur environnement, leur comportement individuel ou leur interaction avec d’autres personnes. Ce projet, organisé en cycles successifs, m’a permis de m’intéresser de manière graduelle aux verrous scientifiques sous différents angles et dans différents contextes applicatifs. Ainsi, tous les 3 mois divers contextes applicatifs tels que les vidéo-conférences, les systèmes d’e-learning ou les expériences multimédia interactives ont été abordés.

Mes publications en lien avec le projet EMPATHIC sont les suivantes : [AJI_DLBD_15][ACI_MABVDC_15][ACI_DLDB_12][ACI_HLBD_14][AWI_AMB_16][AWI_BLDD_14][AWI_BLBBD_14][AWI_BLD_14][ACN_MBA_16][ACN_AMBD_16][ACN_ABL_14][ACN_ALB_14]

TWIRL – Twinning virtual World (on-line) Information with Real world (off-Line) data sources

| ITEA2 - 2012-2014 labellisé en 2010 11 partenaires, 3 pays coordonné par Cassidian Cybersecurity France https://itea3.org/project/twirl.html |  |

Ce projet européen a pour objectif de créer une plateforme capable de traiter, fouiller, établir des liens et fusionner des données en provenance d’applications en relation avec le monde réel (par exemple, estimations du trafic routier, prévisions météorologiques) avec des sources de données en ligne (par exemple, réseaux sociaux, forums, blogs, wikis, RSS). Notre ambition est de résoudre des problématiques liées à la quantité de données disponibles sur Internet, l’hétérogénéité des formats et types de données (par exemple, textes, commentaires, vidéos, images), et la difficulté d’agréger des données provenant de sources multiples. J’ai porté la participation de l’équipe dans ce projet dès ses prémices en février 2010. J’ai eu la charge de définir le budget et d’organiser l’implication de l’équipe dans le projet. Dès le financement du projet, intervenu en février 2012, j’ai coordonné localement les activités de recherche et les recrutements jusqu’en février 2013. Pendant cette période, j’ai mis en place des outils de travail collaboratif (wiki) servant à faciliter les échanges et de capitaliser les avancées au sein du consortium. La tâche du pilotage a ensuite été transférée à mon collègue Jean Martinet (MCF HDR, équipe FOX, lab. CRIStAL). J’ai continué à participer au projet en travaillant dans le cadre du sous-lot 3.4 (Reconnaissance, Extraction, Catégorisation) sur l’extraction d’information portant sur les personnes présentes dans les collections d’images et de vidéos.

Mes publications en lien avec le projet TWIRL sont les suivantes : [AJI_DB_16][AJI_DBM_15][ACI_DBD_13][AWI_DBM_15].